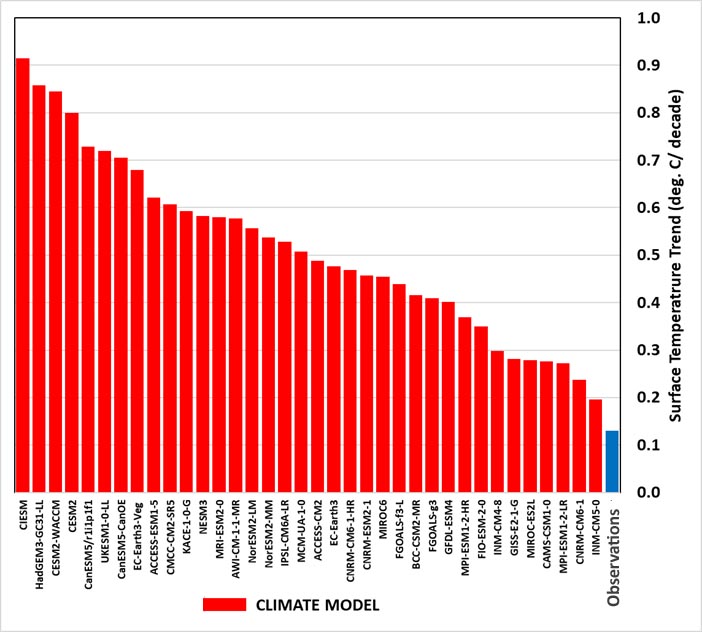

Fig.1 Bron: DoE report 2025

Bovenstaande grafiek is afkomstig uit het recente klimaatrapport dat het Amerikaanse Ministerie van Energie heeft laten maken, geschreven door Steven Koonin, Judith Curry, John Christy, Roy Spencer en Ross McKitrick. De grafiek toont de opwarmingstrends voor de zomermaanden (juni, juli, augustus) van 1973-2022 voor de Corn Belt, een van de belangrijkste agrarische regio’s op aarde. Het rapport concludeert: “All 36 climate models (red) warm far too rapidly compared to observations (blue).” Dat is duidelijk.

Hoe zit het eigenlijk met de betrouwbaarheid van die klimaatmodellen, die in de klimaatwetenschap een ongekend hoge status hebben? Is die status wel terecht? Ad Huijser schreef er een essay over. Huijser studeerde Technische Natuurkunde aan de TU Eindhoven en promoveerde in 1979 aan de TU Twente. In 1994 werd hij benoemd tot “baas” van het beroemde NatLab van Philips, en vanaf 1998 was hij verantwoordelijk voor de wereldwijde Philips Research organisatie. De laatste jaren heeft Huijser zich intensief bezig gehouden met het onderwerp klimaatverandering en toont hij vanwege zijn achtergrond vaak een ‘frisse’ blik op de klimaatproblematiek. Dat hij daarbij af en toe heilige huisjes omver haalt is logisch en onvermijdelijk. Hieronder volgt zijn integrale essay.

Klimaatmodellen: wetenschappelijk bewijs of “nieuwe kleren van de keizer”?

Recentelijk schreef Rob de Vos op zijn website over de invloed van de zon op ons klimaat. Aanleiding daarvoor was een essay dat ik van de zomer schreef als een soort terugblik op ons beider analyses (1). Vijf jaar geleden was het voor mij niet veel meer dan een sommetje op de achterkant van een bierviltje om te laten zien hoe groot de invloed van de toename aan instraling van de zon wel niet was. Dat bleek zo maar tweederde van de opwarming in Nederland te kunnen verklaren, waardoor er voor CO2 als ‘boosdoener’ niet veel meer overbleef. Het KNMI reageerde; kennelijk had ik een gevoelige snaar geraakt. Ik vond hun argumentatie tegen mijn aanpak niet erg bevredigend en besloot me maar eens verder in de klimaatproblematiek te gaan verdiepen. In een paar weken tijd had ik al twee andere manieren gevonden om mijn orde van grootte berekening met feitelijke data te onderbouwen. Het was niet moeilijk om de grote invloed van meer zonneschijn op ons klimaat te kwantificeren. Sindsdien heb ik daar veel uitgebreider en diepgaander over geschreven (2), maar de vraag blijft waarom de overheersende invloed van de zon op de opwarming in ieder klimaatrapport van het KNMI en IPCC nog altijd ontbreekt. Wel hamert men op die ‘vreselijke’ opwarming door groeiende antropogene emissies van broeikasgassen als CO2 of methaan.

De zon bepaalt niet alleen ons klimaat op aarde, maar ook de veranderingen daarin

In bovengenoemde terugblik deed ik het rekenwerk nog eens over, maar nu op basis van de verhouding tussen de stralingsforcing door broeikasgassen en de netto forcing door meer instraling als gevolg van een afname in bewolking. De oude berekening met een verhouding CO2 versus zongerelateerde opwarming van 1 op 2 bleek te mild. Ik kwam voor Nederland tot een CO2-bijdrage aan de opwarming van de laatste decennia van slechts 10%. Met een mijns inziens betere waarde voor de forcingsterkte van CO2 dan die het IPCC gebruikt (3) was dat zelfs nog aanzienlijk lager (1).

In Nederland is de instraling door de zon sinds 1980 met zo’n 15% toegenomen. Dat is niet alleen in West-Europa zo, maar ook wereldwijd laten satellietmetingen sinds 2000 een aanzienlijke groei in de jaarlijkse zoninstraling zien. Ik toonde aan dat zeker meer dan 50% van de mondiale opwarming door méér zon komt. Zelfs de omslag van een koelend naar een opwarmend klimaat tussen 1970 en 1980 moet door de verandering in de instraling zijn veroorzaakt en niet door de groei in de CO2-concentratie (2). In een nog te publiceren artikel over o.a. de sterkte van CO2 als broeikasgas en de klimaatgevoeligheid wordt e.e.a. op een geheel andere wijze ook weer bewezen (3).

In KNMI’s oorspronkelijke reactie op mijn ‘sommetje’ werd o.a. gesteld dat klimaatmodellen iets heel anders voorspellen dan ik berekende. Als je – zoals het KNMI – heilig geloof hecht aan klimaatmodellen, dan is dat voor hen uiteraard een logisch argument. Immers, in dat soort rekenwerk moet inmiddels (conservatief geschat) wereldwijd al wel twee miljard euro zijn geïnvesteerd: 20 jaar x 1000 onderzoekers wereldwijd x € 100.000 per medewerker aan salaris + (computer)kosten per jaar. Hoe durf je dan als amateuristische eenling de uitkomsten daarvan zomaar in twijfel te trekken? Het antwoord is simpel: de uitkomsten van klimaatmodellen passen gewoon niet bij de metingen (2). Zoals Richard Feynman ooit zei: “It doesn’t matter how beautiful your theory is, it doesn’t matter how smart you are. If it doesn’t agree with experiment, it’s wrong”. Mijns inziens de enig juiste conclusie.

Nu zijn die klimaatmodellen in principeniet heel veel meer dan werelddekkende weermodellen waar – voortschrijdend in de tijd – continu een beetje extra CO2 aan de atmosfeer wordt toegevoerd. Weermodellen leveren qua weersvoorspellend vermogen best wel goede resultaten. Voor het Nederlandse weer is een week vooruit voorspellen misschien nog niet heel veel beter dan het opgooien van een muntje, maar trendmatig zijn ze echt wel goed. Bovendien, weersvoorspellingen worden regelmatig (meestal om de zes uur) weer ververst op basis van de laatste metingen die dan als nieuwe startwaardes worden gebruikt. Zo wordt er geleidelijk aan een steeds betere verwachting geschetst. Vijf dagen later zijn we die oude, nog enigszins twijfelachtige voorspelling van een week geleden voor morgen en overmorgen dan ook al lang weer vergeten.

Koffiedik kijken

Patrick Frank [4] heeft al jaren geleden een goed onderbouwde beschouwing gepubliceerd waarom klimaatmodellen niet geschikt zijn voor langetermijnvoorspellingen. De kritiek is daarbij niet zozeer op de fysica met als basis de Navier-Stokes-vergelijkingen die in de weermodellen worden gebruikt, maar meer op de rekenmethodiek. De voorspelling wordt namelijk berekend door steeds vaste stappen in de tijd te maken, waarbij de output van de eerste rekencyclus de input van de volgende rekencyclus voor de toestand 3 of 6 uur later is. Dat proces herhaalt zich in de daaropvolgende rekenstappen. Daarbij zullen afrondingsfouten en kleine systematische afwijkingen in de fysische afhankelijkheden tussen de vele parameters in zo’n model door foutenpropagatie een steeds grotere afwijking opleveren. Alle grid-parameters in de startfase moeten zo’n 1% nauwkeurig zijn, hetgeen voor druk en temperatuurmetingen al a hell of a job is. Zelfs dan gaat het al na zo’n 50-100 rekencycli zodanig fout dat de voorspelling waardeloos wordt. Door het programma een aantal keren te doorlopen met kleine variaties in de startparameters wordt de weersverwachting door ensemble middeling wel verbeterd, maar het chaotische weer blijft moeilijk voorspelbaar. Met 4 tot 8 cycli per etmaal loopt de voorspelling dus na zo’n 10 tot 15 dagen uit op niets meer dan een soort random weer, zeg maar het klimatologisch gemiddelde van die maand in het jaar.

Dat is juist ook weer het argument om klimaatmodellen wel te vertrouwen, want die moeten immers alleen de klimatologische veranderingen berekenen. Maar ook dáárvoor geldt het probleem van systematische foutenpropagatie. Dat speelt juist in klimaatvoorspellingen een veel bepalender rol omdat de eens gekozen startwaarden daarna niet meer gereset kunnen worden. Bij klimaatmodellen die 75 jaar of langer vooruit moeten kijken is dat aantal rekencycli al gauw zo’n 200.000. Dat vraagt om 3 ordes nauwkeuriger startwaardes, maar ook 3 ordes kleinere systematische afwijkingen dan die orde van 1% bij weermodellen.

Helaas ontbreken er allerlei fysisch goed gedefinieerde relaties binnen het klimaatsysteem. In plaats daarvan werken die modellen met (empirisch) geparameteriseerde verbanden tussen belangrijke, interactieve effecten als bewolking, vochtigheid, sneeuw- en ijsbedekking, oceaanstromen en nog vele andere invloeden. Dat gaat gewoon niet lukken, ook niet als we de noodzaak van een veel betere laterale resolutie even ‘vergeten’ die nodig is om het effect van met name bewolking goed te simuleren. NASA schrijft op de website van het International Satellite Cloud Climatology Project(ISCCP) [5] dat klimaatmodellen daarin nog zeker een factor 100 (!) te kort schieten om iets zinnigs op te leveren. Zo’n opmerking staat natuurlijk wel haaks op hun klimaatalarmisme dat ze al tijden breeduit verkondigen. Willis Eschenbach heeft ooit op WUWT [6] laten zien hoe dit soort klimaatmodelleurs uit hun modellen door een outputgericht selectieproces een resultaat weten te destilleren waardoor het net lijkt of die modellen toch zinvolle output leveren.

Blind vertrouwen in de wetenschap is niet-wetenschappelijk

Heel veel klimaatwetenschappers lijken ook een blind vertrouwen te hebben in dit soort modellen en de output ervan als input voor hun eigen onderzoek te gebruiken. Ik vermoed dat ze nog nooit gekeken hebben naar hoe die modellen werken, noch enig idee hebben van de betrouwbaarheid van die voorspellingen. Helaas is er ook weinig inhoudelijks gepubliceerd over hoe deze modelleurs tot hun resultaten komen, maar wát erover gepubliceerd wordt roept nogal wat vragen op. In Mauritsen et al[7] kunnen we lezen hoe de klimaatgroep van het Max Planck Institut für Meteorologiein Hamburg hun klimaatmodellen aanpast (tunen is de technische term) om maar vooral een goede ‘voorspelling’ van het temperatuurverloop van de afgelopen eeuw (backcast) te genereren. Reden: hun ‘vrij’ draaiende klimaatmodellen liepen qua opwarming wel erg hard uit de hand. Uitgedrukt als Equilibrium Climate Sensitivity (ECS) resulteerden die in een temperatuurverhoging bij 2xCO2 van wel 7 °C. Dat vonden ze (terecht) te gortig. Door eerst het verleden te simuleren en de parameters in het model te tunen om de resultaten daarmee dekkend te krijgen, leverde dat een ECS ≈ 3 °C. Of beter gezegd, ze stelden vooraf een ECS van 3 °C als doel. Vervolgens draaiden ze aan allerlei ‘knoppen’ in hun model, met name de belangrijke cloud feedback, om zo het bekende ‘verleden’ te simuleren. Wat daarvan de onbedoelde neveneffecten in hun model zijn is echter niet duidelijk.

Deze prestigieuze Duitse klimaatgroep draait al jaren mee in het Climate Modeling Intercomparison Project(CMIP) en hun publicatie gaat over de meest recente 6e generatie CMIP6-klimaatmodellen. Daaraan deden 49 (!) onderzoeksgroepen mee (daarom mijn eerdere schatting van 1000 onderzoekers) met zo’n 100 verschillende klimaatmodellen. Via onderlinge uitwisseling van informatie binnen dit project mag je dus verwachten dat meerdere groepen een dergelijk tuning-proces toepassen. Dan mag je ook verwachten dat al die CMIP6-berekende ECS-waardes redelijk overeenkomen, maar dat blijkt niet uit de resultaten. Er zit nog altijd een bandbreedte van méér dan een factor 3 (!) tussen de hoogste en laagste ECS [1]. Dit past weer niet bij de minimale eis waaraan klimaatmodellen zouden moeten voldoen om enigszins kredietwaardig te zijn: ze moeten het recente verleden natuurlijk wel redelijk accuraat kunnen simuleren. Zo niet, dan voldoen ze niet aan het Feynman criterium en moeten dus per definitie fout zijn.

Klimaatmodellen die het recente verleden niet goed kunnen simuleren moeten fout zijn

Als het om de temperatuurstijging gaat, zitten er voor een goede ‘voorspelling’ van het verleden (afgezien van interne fysische eigenschappen) feitelijk maar twee extern te variëren factoren in die modellen. Dat zijn de hoeveelheid opwarmende broeikasgassen als CO2 en CH4 en een groep van overwegend afkoelende aerosolen zoals SO2, maar ook zout- en stofdeeltjes als Sahara-zand in de atmosfeer. Bij deze laatste groep horen ook de uitstoot van bekende vulkanische erupties die tijdelijk wat koeling brengen. De mooi gesimuleerde dips met zorgvuldig gekozen decay-tijden in de grafisch gepresenteerde output passen altijd precies bij de metingen. Niet vreemd, want ze worden er gewoon vooraf ingestopt; vulkaanerupties zijn immers niet te voorspellen.

Maar wat ondanks de vaak imponerende overeenkomsten tussen simulaties en metingen vooral opvalt, is dat eigenlijk alleen de opwarming na 1980 enige discriminatie oplevert t.a.v. de gekozen broeikasgas- en aerosolen concentraties. Niet zo vreemd, ze tonen immers niet de absolute temperaturen, maar alleen de anomalieën, afwijkingen van het gemiddelde of van de te verwachten waardes. Voor 1980 waren er afwisselend wat warmere en wat koelere periodes met alleen incidentele afwijkingen van een langzaam oplopende temperatuur. Daarbij moet men ook bedenken dat de wereldwijde gemiddeldes voor die tijd vaak ge(re)construeerde data zijn en daarom niet al te betrouwbaar. Dan blijven er voor het echte tunen van die modellen eigenlijk alleen de sterk oplopende temperaturen na 1980 over. Daarmee ligt de bijbehorende ECS in feite ‘keihard’ vast middels de goed gemeten temperaturen en CO2-concentraties. Voldoet een model bij benadering daar niet aan, dan kan de model-output het verleden simpelweg nooit goed dekkend krijgen, aan welke van de vele knoppen in zo’n model men ook draait. Die modellen moeten dan ook absoluut zeker fout zijn.

Met IPCC’s AGW-hypothese dat alle recente opwarming een gevolg is van broeikasgassen als CO2, zitten alleen nog de temperatuurtrend dT/dt en de trend in CO2-concentratie d/dt log[CO2] in de waarde van de ECS [3]. De CO2-concentratie is zeker vanaf 1960, toen men die consistent is gaan meten, nagenoeg exponentieel gestegen. Dit betekent dat die trend in de logaritme van de CO2-concentratie constant is met 0,66/eeuw [2]. De gemeten temperatuurtrend na 1980 ligt ergens tussen de 1,6 – 2,3 °C/eeuw, afhankelijk van de diverse temperatuurreeksen die we kennen [2]. Alle opwarming sinds 1980 toeschrijvende aan de toename in CO2 geeft dit op basis van deze twee gemeten trends een ECS = log2*(dT/dt)/(d/dt log[CO2]) ≈ 1,7 – 2,5 °C. In mijn terugblik bleek dat van de 33 door het KNMI uitverkoren CMIP6-modellen voor hun klimaatscenario’s 2023, er maar vier voldeden aan de eis van een ECS < 2,5 °C en niet één haalde 1,7 °C [1]. Zelfs de 3 °C die de Max Planck-groep in Hamburg kennelijk als ‘optimaal’ beschouwt, is aan de hoge kant; en gezien het verschil met ECS = 1,7 oC op basis van de meest betrouwbare temperatuurreeks, ook nog veel te hoog.

Natuurlijk zijn de criteria t.a.v. wat is dekkend in dit soort simulaties altijd behoorlijk rekbaar. Het is dan ook niet verwonderlijk dat Mauritsen et al[7] ondanks een toch nog veel te hoge ECS = 3°C zeer trots zijn op de kwaliteit van hun modellen. Ze zeggen het er nog net niet expliciet bij, maar in feite staat er ‘bewijs geleverd‘. Niet alleen dat hun model ‘heel goed’ is, maar ook dat de Anthropogenic Global Warming (AGW)-hypothese van het IPCC de enig correcte verklaring voor de geconstateerde opwarming is. Op de website van hun instituut wordt dit ‘bewijs’ al jaren geclaimd als een van hun grootste successen. En dan te bedenken dat ze die match alleen bereiken door aan essentiële en fysisch gezien, zeer relevante knoppen als bv. cloud feedback te draaien. Beter hadden ze de gebruikte forcing-sterkte van CO2 drastisch kunnen verlagen, maar die moest kennelijk binnen de CMIP6-bandbreedte van 3,9 + 0,5 W/m2 blijven. Nog zo’n onwaarschijnlijk hoge waarde die uniform uit het merendeel van die modellen komt en er dus vooraf, weliswaar impliciet, toch ingestopt lijkt. Op basis van radiation transfer berekeningen kom ik maar op 2,0 W/m2, een waarde die heel wat beter past bij de stralingseigenschappen van CO2-moleculen en veel dichter ligt bij de enige, op basis van satelliet-metingen bepaalde waarde [2,3]. Dat levert maar een zeer geringe ECS ≈ 0,72 °C die een factor 4 kleiner is dan die 3 °C. Maar bij die berekeningen wordt de invloed van de zon in de opwarming sinds 1980 dan ook niet opzettelijk vergeten en dat scheelt een slok op een borrel.

De invloed van CO2 op ons klimaat is qua sterkte al een halve eeuw redelijk goed bekend

De echt wel imposante klimaatmodellen die voor bepaalde deelproblemen een zeer interessant instrument zijn om input-output effecten te simuleren, hebben dus sowieso een serieuze tekortkoming: de invloed van de zon wordt niet echt meegenomen. Merkwaardig, want de zon is de enige bron van opwarming; meer CO2 onderdrukt slechts de afkoeling. Zoals vermeld kunnen we dat laatste met goed verifieerbare fysica uitstekend uitrekenen. Mijn zo berekende ECS ≈ 0,72 °C [3], is nagenoeg identiek aan hetgeen NASA-onderzoekers 54 jaar geleden ook al berekenden [7]. NASA gaf toen zelfs een persbericht uit over deze geringe opwarming door een verdubbeling van de CO2-concentratie. Wat is er sindsdien in de basale fysica toch veranderd waardoor NASA’s huidige inschatting voor het veronderstelde effect van CO2 inmiddels 4x zo groot is geworden? [2].

De wiskundige John von Neumann schijnt ooit over computermodellen te hebben gezegd: “Met vier parameters kan ik een olifant simuleren, en met vijf kan ik hem ook zijn slurf laten wiebelen”. Dat zal overigens niet de reden zijn waarom men het effect van een veranderde instraling van de zon niet meeneemt in dit soort klimaatmodellen. Nog meer parameters die kunnen variëren zouden het tunen van zo’n model immers wel makkelijker maken. Helaas kunnen we niet goed verklaren waarom in Nederland de hoeveelheid zon met zo’n 15% is toegenomen sinds 1980 [1], anders dan dat de lucht kennelijk ‘schoner’ is geworden. Dit betekent dat je zo’n klimaatverschijnsel ook helemaal niet kunt modelleren. En wat je niet in een model kunt stoppen, komt er qua mogelijk effect ook nooit uit. Bovendien, het effect van het schoner worden van de atmosfeer door het stoken van aardgas i.p.v. kolen sinds het midden van de jaren ’70 moet inmiddels wel uitgewerkt zijn. Dan blijft er voor de modelberekeningen enkel nog de bekende toename in de CO2-concentratie over als oorzaak van de gemeten opwarming. Dat is geen bewijs voor IPCC’s CO2-gebaseerd AGW-narratief zoals het Max Planck Institut für Meteorologieclaimt, maar bewijst enkel ons collectief gebrek aan kennis over de drijvende krachten binnen ons klimaat. Klimaatmodellen ‘bewijzen’ namelijk nooit meer dan er vooraf is ingestopt. Elke keer weer zie je dat modelleurs op allerlei gebieden dat basisprincipe maar al te makkelijk vergeten. Voor hen is hun model kennelijk identiek aan de echte wereld.

Dat de zon veel invloed heeft en dus absoluut niet te verwaarlozen is, weten we uit het temperatuurverloop van de seizoenen; meer uren zon na de winter leidt tot hogere temperaturen. Na augustus, als de dagen korter worden, neemt de temperatuur ook weer af. Volhouden dat de geconstateerde toename in de gemiddelde jaarlijkse instraling door de zon maar weinig bijdraagt aan de opwarming, zoals het KNMI doet, is werkelijk onvoorstelbaar. Een wel heel merkwaardige vorm van ‘klimaatontkenning’. Net als het hierboven beschreven tunen van modellen om de gewenste uitkomst te krijgen, is dat wetenschappelijk gezien een twijfelachtige vorm van selectief shoppen. Netjes uitgedrukt natuurlijk, want in de volksmond heet dat ongetwijfeld anders.

Als ze echt zo goed weten hoe het klimaat werkt, moet men net als in andere fysische disciplines hun klimaatmodellen ab initio de huidige staat van het klimaat laten uitrekenen. Je kan er vergif op innemen dat die uitkomsten helemaal niet zullen kloppen met de werkelijkheid. Steven Koonin beschrijft in zijn boek Unsettled? dat het op een paar graden nauwkeurig berekenen van de gemiddelde absolute (!) temperatuur van de aarde met deze modellen veelal niet lukt [9]. Als dat soort essentiële uitkomsten al niet kloppen, kan zo’n model nooit heel erg goed zijn. Maar dat is kennelijk een ‘ouderwetse’ wetenschappelijke wijsheid die voor klimaatwetenschappers blijkbaar niet meer geldt. Zouden deze wetenschappers echt geloven dat hun modellen de werkelijkheid benaderen omdat ze de output door manipulatie kloppend hebben kunnen maken met de gemeten opwarming? Het klimaatdashboard van het KNMI [1] laat in ieder geval overduidelijk zien dat deze CMIP6-modellen de gemeten toename in de instraling door de zon totaal niet voorspellen. Wat is die gefabriceerde ‘match’ met de temperaturen van de laatste decennia dan in feite nog waard?

Voorspellingen of ‘wensdenken’ op basis van een heilig geloof?

De ECS ≈ 3 °C als IPCC’s most likely waarde voor de opwarming door hogere CO2-concentraties in de atmosfeer moet niet alleen gezien de eerdergenoemde fysisch berekende waarde van ≈ 0,72 °C maar ook op basis van het verleden als onnatuurlijk hoog worden bestempeld [3]. Als men álle opwarming aan het effect van CO2 toeschrijft, zoals het IPCC in hun AGW-hypothese doet, dan moet ons klimaat zich namelijk in een steady state bevinden [3]. De ECS-waarde is dan niet ingewikkelder dan de verhouding van de temperatuurtrend en de trend in de logaritme van de CO2-concentratie, zoals hierboven al gesteld [2,3]. Bij gebrek aan andere opwarmingsmechanismen dan CO2, moet daar op basis van de metingen een ECS van maximaal 2,5 °C of m.i. zelfs maar 1,7 °C uit komen [2]. IPCC’s 3 °C halen we zelfs niet met de (te) hoge HadCRUTv5 temperatuurtrend. We moeten die waarde dan ook maar zien als passend bij het alarmistisch overdrijven van de ‘vreselijke’ effecten van onze CO2-uitstoot. KNMI’s projectie van 1,2 meter zeespiegelstijging aan het eind van de eeuw is ook opzettelijk overdreven. Voorspellingen van een op handen zijnde ijsvrije Noordpool kennen we ook al 20 jaar.

Laten we nu eens kijken naar voorspellingen voor de toekomst op basis van dit soort getunede klimaatmodellen. Daarvoor kunnen we stellen dat zo’n uit het verleden vastgelegde ECS als hierboven beschreven, tevens de ECS-waarde is die de toekomstige opwarming bepaalt. Die stelling is gebaseerd op de klimaatgevoeligheid als intrinsieke eigenschap van ons klimaatsysteem. Het gebruik van ECS als parameter voor de klimaatgevoeligheid door met name het IPCC is helemaal geënt op de AGW-hypothese dat alle opwarming het resultaat is van CO2. Het beschrijft in feite de temperatuurverhoging die nodig is om de verstoring van de stralingsbalans door een verdubbeling in de CO2-concentratie te compenseren. Iedere verstoring van de stralingsbalans, zoals meer instraling als gevolg van minder bewolking, leidt op dezelfde wijze ook tot opwarming. Een temperatuurverhoging zorgt immers dat de betreffende verstoring van de stralingsbalans tussen binnenkomende- en uitgaande straling te niet wordt gedaan. Deze intrinsieke klimaatgevoeligheid, de verhouding tussen temperatuurverhoging en stralingsonbalans, heeft dan ook niets met CO2 te maken maar is met name gekoppeld aan al het water in ons klimaatsysteem [2]. Onze aardse temperaturen laten toe dat alle drie de aggregatietoestanden van water met hun unieke eigenschappen in ruime mate aanwezig zijn. Niet alleen de enorme hoeveelheid vloeibaar water in onze oceanen, maar ook het water in vaste vorm als sneeuw en ijs, of als gas in de vorm van waterdamp in de atmosfeer en als kleine druppels in de bewolking. Kleine temperatuurveranderingen beïnvloeden de verdeling van water over die verschillende aggregatietoestanden. Juist dát soort temperatuur gedreven herverdelingen bepalen de intrinsieke klimaatgevoeligheid. Het gewone broeikaseffect dat onze aarde leefbaar maakt, is daaraan gerelateerd en wordt voor 85% bepaald door water. De bewolking is goed voor 65% terwijl 20% wordt bepaald door waterdamp als sterkste broeikasgas in de atmosfeer. De resterende 15% komt van CO2 en kleine concentraties aan methaan en ozon [3]. De invloed van CO2 is dus klein. De concentratie moet zelfs verdubbelen om de Aarde 0,72 °C op te warmen, maar deze kleine 0,25% verandering in de absolute temperatuur zal de intrinsieke klimaatgevoeligheid niet significant veranderen. Ook de ECS moet dan binnen al die rekencycli van een klimaatmodel, in de tijd constant blijven.

Klimaatangst creëren of een realistische kijk op de toekomst bieden?

Aangezien de ECS zoals eerder uitgelegd, niet altijd vrij berekend wordt door het klimaatmodel maar meestal al vastligt door het tunen van het ‘voorspelde’ verleden, is ook de toekomstige opwarming daarmee vastgelegd. Het voorspelde temperatuurverloop naar de toekomst is dan niets anders dan de historisch bepaalde ECS vermenigvuldigd met de trend in de logaritme van de CO2-concentratie. Deze laatste trend is voorgeschreven in het gebruikte IPCC RCP/SSP-scenario waarmee we in het model de CO2-concentratie laten toenemen. Voor het berekenen van de opwarming hebben we dus helemaal geen supercomputer nodig, zelfs geen laptop of PC. Met een ouderwetse rekenliniaal kan iedereen dat zonder elektronische hulpmiddelen heel eenvoudig doen. Het recept is immers simpel: gebruik de temperatuurtrend van de laatste vier decennia, deel die door de trend d/dt log[CO2] = 0.66/eeuw over dezelfde periode. Dat levert de waarde ECS/log2, waarbij de ook eerder gebruikte log2-term komt door de definitie van ECS als effect van de verdubbeling van de CO2-concentratie. Afhankelijk van de gekozen temperatuurtrend is ECS/log2 iets als 2.5 – 3.6 °C. Als dat getal vervolgens met de trend d/dt log[CO2] van het gewenste IPCC-RCP/SSP-scenario wordt vermenigvuldigd, krijgen we precies de toekomstige temperatuurtrend van onze planeet.

Als voorbeeld berekenen we hier de temperatuurverhoging volgens het IPCC RCP8.5 – een extreem en onrealistisch scenario dat echter tot enkele jaren geleden gezien werd als het business as usual-scenario – waar ook KNMI’s voorspelling van 1,2 m zeespiegelstijging op is gebaseerd. Het getal 8.5 slaat op de groei in forcing (W/m2) van alle broeikasgassen in 2100 t.o.v. 1850-1900. Voor de trend in log[CO2] moeten we dan naar de CO2-equivalente groei kijken zoals die ook gebruikt is in de trend van 0,66/eeuw in de bepaling van de ECS [2]. Voor de eenvoud en transparantie, berekenen we hier slechts het CO2-aandeel in de opwarming, dat met meer dan 75%, toch de grootste bijdrage levert. In RCP8.5 stijgt die CO2-concentratie van de huidige 425 ppm naar 940 ppm in 2100. Dus met ECS = 2,5 °C en log(940/425) ≈ 0,8 moet de aarde in 2100 daardoor nog 2,9 °C warmer worden dan nu. IPCC’s most likely ECS = 3.0 °C, levert in dit RCP8.5 scenario zelfs bijna 3,5 °C stijging met een 2x hogere opwarmsnelheid tot 2100 dan we de laatste 35 jaar hebben gemeten. Het laat meteen de absurditeit van dit RCP8.5-scenario zien.*

Maar aangezien slechts weinigen weten hoe men tot dat soort voorspellingen komt, kan het IPCC bijna iedereen wijsmaken dat op basis van ‘de wetenschap’ er geen toekomst voor de mensheid meer bestaat als we niet onmiddellijk met die antropogene uitstoot stoppen. Het is gewoon het prediken van hel en verdoemenis zonder dat gewone stervelingen kunnen verifiëren of het allemaal waar is.

Aan deze zogenaamd wetenschappelijk onderbouwde boodschap van het IPCC heeft men dus inmiddels minimaal 2 miljard euro uitgegeven. Niet dat het allemaal weggegooid geld is want de klimaatwetenschap is er echt wel mee vooruit geholpen, maar voor de temperatuurvoorspellingen had dezelfde boodschap ook voor niks verkregen kunnen worden. Immers, we hebben er helemaal geen klimaatmodel voor nodig, maar slechts het wetenschappelijk onbewezen geloof dat de gemeten opwarming sinds 1980 uitsluitend het gevolg is van onze antropogene uitstoot van CO2.

Klimaat-alarmisme leidt niet tot een veel beter, maar wel een heel ander “klimaat”

En daar is inmiddels een (weliswaar alleen door Westerse overheden) uit uw belastinggeld zwaar gesubsidieerde miljardenindustrie op gebaseerd waar de grootste uitstoter van CO2 op de wereld (China) nog het meest van profiteert. Ook vliegen er elk jaar tienduizenden AGW-gelovigen totaal onnodig de wereld rond, om bij de volgende COP-bijeenkomst te zijn. De carbon footprint van dat soort Poolse landdagen laat zien dat de deelnemers zelf weinig om ‘het klimaat’ geven. Hun ruime aanwezigheid dient m.n. om de achterliggende IPCC-mythe/religie in stand te houden. Ongetwijfeld ook om te lobbyen’ voor een nog grotere berg subsidiegeld om op te kunnen blijven parasiteren. Ze zijn immers overtuigd dat klimaatmodellen echt de toekomst voorspellen en dat zij de uitverkorenen zijn om de mensheid te behoeden voor die anders onvermijdelijke rampen van ‘verdrinkende’ eilanden, ‘kokende’ zeeën en een ‘onleefbare’ planeet waardoor het einde der mensheid nabij is. Over de zichzelf aan de weg-vastplakkende, soep-over-kunstwerken-gooiende en maatschappij-ontwrichtende fanaten van XR en Stop Oil zullen we het hier maar niet hebben. Daarvoor geldt net als voor het merendeel van die COP-deelnemers dat ze niet beseffen hoe ze gemanipuleerd worden met uitkomsten uit modellen die niet meer zijn dan een simpele extrapolatie van een verkeerde hypothese over de opwarming sinds 1980. Allemaal zijn ze jarenlang, net als vele gewone burgers en m.n. de jeugd, geïndoctrineerd met een niet bewezen en zelfs feitelijk onjuist narratief dat alle opwarming van de laatste eeuw een gevolg is van broeikasgassen. Kennelijk onbewust dat ze niet meer dan figuranten zijn in een klimaatsoap die inmiddels al heel veel lijkt op het bekende sprookje van Hans Christian Andersen: de nieuwe kleren van de keizer.

Ad Huijser, oktober 2025

- Huijser A. (2025), https://www.klimaatgek.nl/document/Huijser%20zon%20en%20CO2.pdf

- Huijser, A. (2025), Global Warming and the ‘impossible” Radiation Imbalance, Science of Climate Change 3, 81-106. https://doi.org/10.53234/scc202510/05

- Huijser A (2025), Why GCMs cannot be trusted: CO2-forcingstrength and Equilibrium Climate Sensitivity in an all-sky atmosphere, wordt binnenkort gepubliceerd

- Frank, P. (2019), Propagation of Error and the Reliability of Global Air Temperature Projections, Front. Earth Sci. 7, 223, https://www.frontiersin.org/articles/10.3389/feart.2019.00223/full

- NASA, https://isccp.giss.nasa.gov/role.html /Cloud Climatology: Computer Climate Models

- Eschenbach W. (2021), https://wattsupwiththat.com/2021/03/12/there-are-climate-models-and-there-are-climate-models/

- Rasool S. & Schneider S. (1971), Atmospheric Carbon Dioxide and Aerosols: Effects of Large Increases on Global Climate, Science 173, 138, https://doi.org/10.1126/science.173.3992.138

- Mauritsen, T., & Roeckner, E. (2020), Tuning the MPI-ESM1.2 global climate model to improve the match with instrumental record warming by lowering its climate sensitivity, J. of Advances in Modeling Earth Systems, 12, https://doi.org/10.1029/2019MS002037

- Koonin, S. E. (2021), Unsettled ? , BenBella Books Inc., ISBN 9781950665792

- Le Pair C. & Huijser A. (2020), How does our CO2 escape?, https://www.clepair.net/oceaanCO2-4.html

* De 3,5 °C temperatuurstijging in 2100 met IPCC’s ECS = 3 oC en het RCP8.5-scenario, moet worden vergeleken met een stijging van 0,83 °C in 2100 volgens mijn meer realistische ECS = 0,72 °C. Bij dit RCP8.5-scenario dat vaak door alarmisten wordt misbruikt om paniek te zaaien, is dit nog altijd (zelfs t.o.v. pre-industrieel) binnen de 1,5 °C van het Parijs klimaatakkoord. Bij de huidige uitstoot (dus echt business as usual) zal de maximum CO2-concentratie in de atmosfeer bij ongeveer 600 ppm stabiliseren [10]. Zo’n veel realistischer scenario, leidt slechts tot 0,36 oC voor het CO2-aandeel in een nog te verwachten stijging van de gemiddelde temperatuur. Het maakt direct duidelijk dat stoppen met het gebruik van fossiele brandstoffen niet heel veel (meer) gaat helpen. Let wel, het gaat hierbij alleen over de CO2/broeikasgas-gerelateerde opwarming die we eventueel zouden kunnen beïnvloeden met net zero-beleid en een sterke reductie van de veestapel. Extrapoleren we de huidige trend incl. de opwarming door meer zon van 0,016 °C/jaar [2], dan zal het in 2100 maximaal 1,2 °C warmer worden. Wat de zon de komende tijd daaraan blijft bijdragen of nog aan toevoegt, is echter niet te voorspellen.